1 月 30 日,继空间感知模型、具身大模型与世界模型“三连发”后,蚂蚁灵波科技今日宣布开源具身世界模型 LingBot-VA。LingBot-VA 首次提出自回归视频-动作世界建模框架,将大规模视频生成模型与机器人控制深度融合,模型在生成“下一步世界状态”的同时,直接推演并输出对应的动作序列,使机器人能够像人一样“边推演、边行动”。

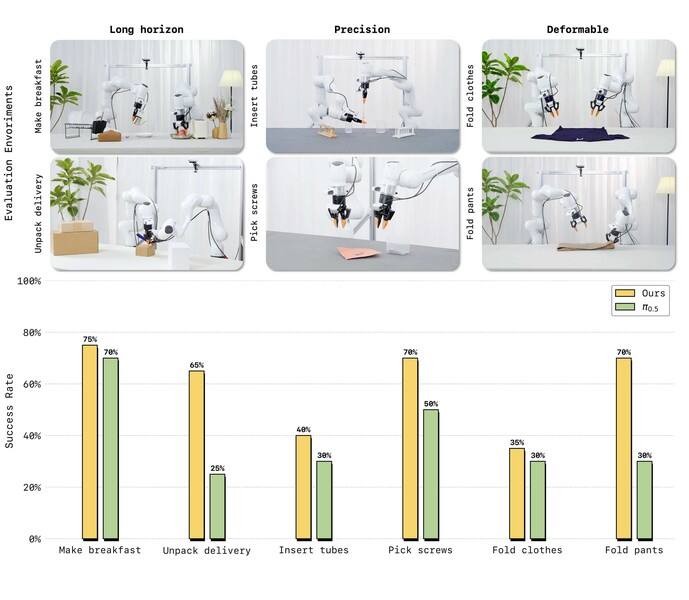

在真机评测中,LingBot-VA展现出对复杂物理交互的强适应能力。面对长时序任务(制作早餐、拾取螺丝)、高精度任务(插入试管、拆快递)以及柔性与关节物体操控(叠衣物、叠裤子)这三大类六项高难度挑战,仅需 30~50 条真机演示数据即可完成适配,且任务成功率相较业界强基线 Pi0.5 平均提升20%。

(真机评测中,LingBot-VA在多项高难操作任务上性能超越业界标杆 Pi0.5)

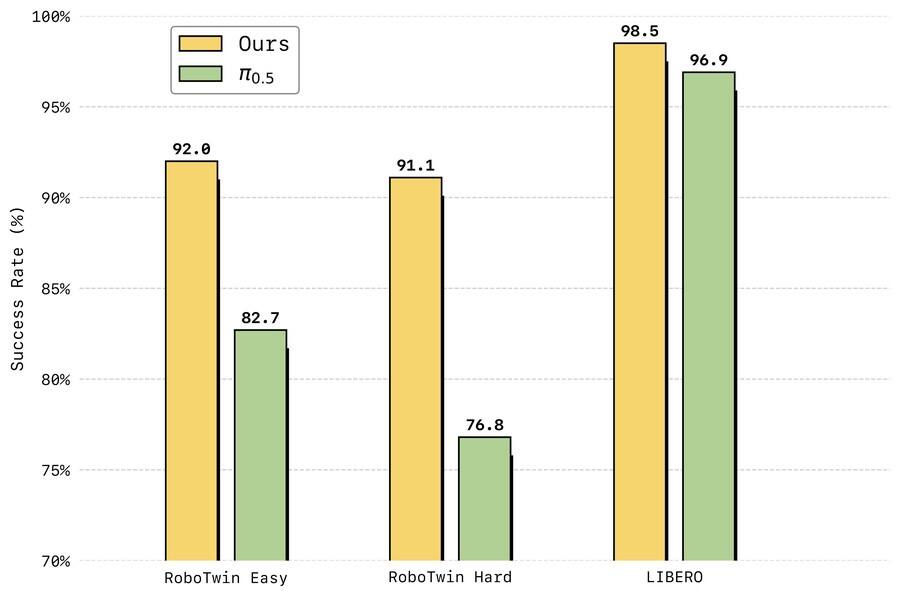

在仿真评测中,LingBot-VA在高难度双臂协同操作基准 RoboTwin 2.0 上首次将成功率提升至超过 90%,在长时序终身学习基准 LIBERO 上达到 98.5% 平均成功率,均刷新了行业纪录。

(LingBot-VA 在LIBERO与RoboTwin 2.0仿真基准测试中刷新现有SOTA)

据悉,LingBot-VA 采用 Mixture-of-Transformers(MoT)架构,让视频处理与动作控制实现跨模态融合。通过独特的闭环推演机制,模型在每一步生成时都会纳入真实世界的实时反馈,确保持续生成的画面与动作不偏离物理现实,从而控制机器人完成高难复杂任务。

为突破大规模视频世界模型在机器人端侧落地的计算瓶颈,LingBot-VA 设计了异步推理管线,将动作预测与电机执行并行化处理;同时引入基于记忆缓存的持久化机制与噪声历史增强策略,让推理时只需更少生成步骤即可输出稳定、精确的动作指令。这一系列优化使得 LingBot-VA 既拥有大模型的理解深度,又具备真机低延迟控制的响应速度。

蚂蚁灵波表示,承接前几日开源发布的 LingBot-World(模拟环境)、LingBot-VLA(智能基座)与 LingBot-Depth(空间感知),LingBot-VA 探索出一条“世界模型赋能具身操作”的全新路径。蚂蚁集团将持续依托 InclusionAI 社区开源开放,与行业共建具身智能基础能力,加速构建深度融合开源开放、且服务于真实产业场景的AGI生态。

目前,LingBot-VA 的模型权重、推理代码已全面开源。