继昨日开源高精度空间感知模型 LingBot-Depth后,蚂蚁集团旗下灵波科技今日宣布全面开源具身大模型 LingBot-VLA。作为一款面向真实机器人操作场景的“智能基座”,LingBot-VLA 实现了跨本体、跨任务泛化能力,并大幅降低后训练成本,推动“一脑多机”走向工程化落地。

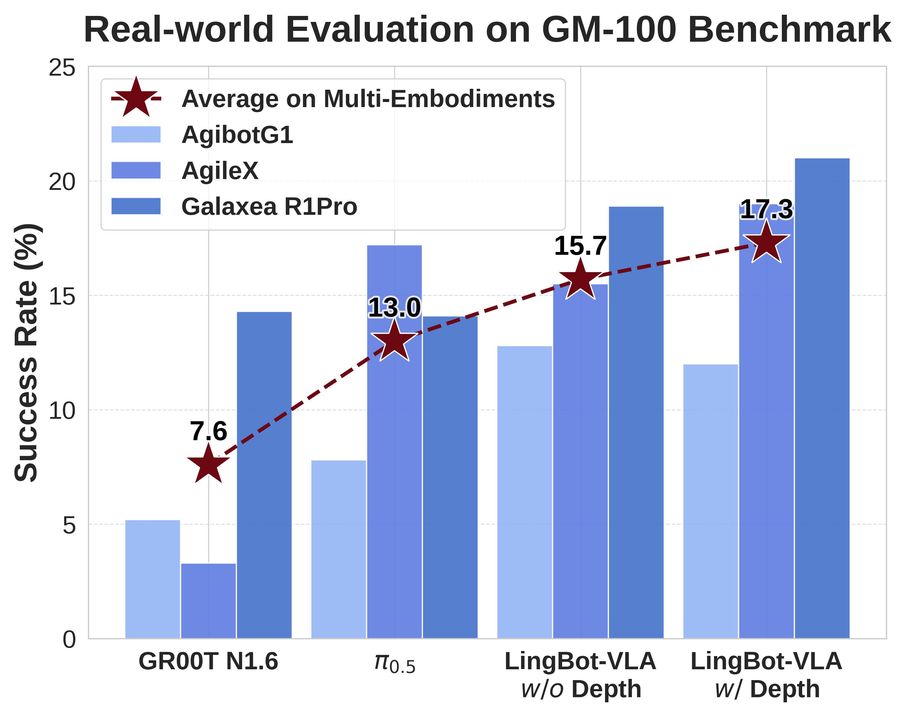

在上海交通大学开源的具身评测基准 GM-100(包含 100 项真实操作任务)测试中,LingBot-VLA 在 3 个不同的真实机器人平台上,跨本体泛化平均成功率相较于 Pi0.5 的 13.0% 提升至 15.7%(w/o Depth)。引入深度信息(w/ Depth)后,空间感知能力增强,平均成功率进一步攀升至 17.3%,刷新了真机评测的成功率纪录,验证了其在真实场景中的性能优势。

(在 GM-100 真机评测中,LingBot-VLA 跨本体泛化性能超越 Pi0.5)

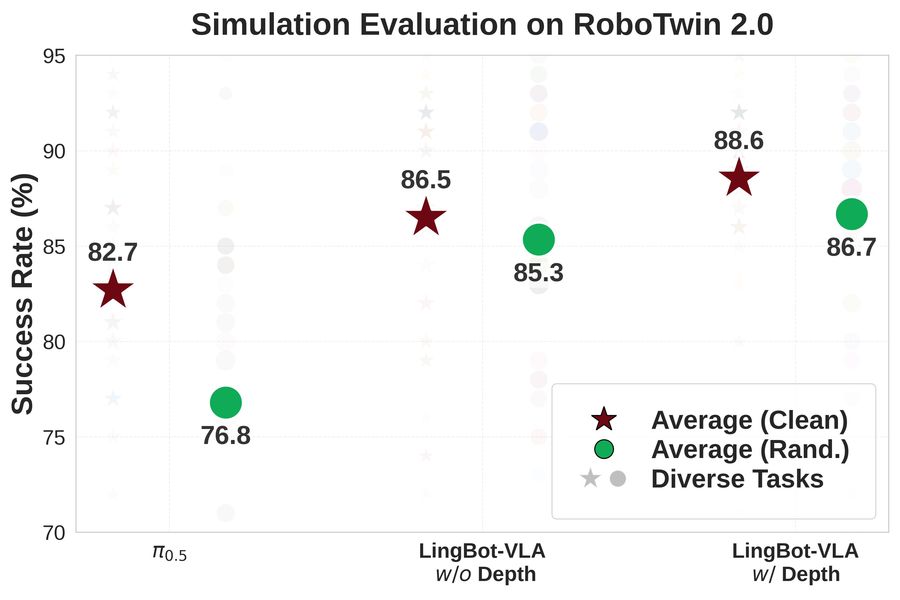

在 RoboTwin 2.0 仿真基准(包含50项任务)评测中,面对高强度的环境随机化干扰(如光照、杂物、高度扰动),LingBot-VLA 凭借独特的可学习查询对齐机制,高度融合深度信息,操作成功率比 Pi0.5 提升了 9.92%,实现了从虚拟仿真到真实落地的全方位性能领跑。

(在 RoboTwin 2.0 仿真评测中,LingBot-VLA 跨任务泛化性能超越 Pi0.5)

长期以来,由于本体差异、任务差异、环境差异等,具身智能模型落地面临严重的泛化性挑战。开发者往往需要针对不同硬件和不同任务重复采集大量数据进行后训练,直接抬高了落地成本,也使行业难以形成可规模化复制的交付路径。

针对上述问题,LingBot-VLA 基于 20000+ 小时大规模真机数据进行预训练,覆盖了 9 种主流双臂机器人构型(包括 AgileX,Galaxea R1Pro、R1Lite 、AgiBot G1等),从而让同一个“大脑”可以无缝迁移至不同构型的机器人,并在任务变化、环境变化时保持可用的成功率与鲁棒性。与高精度空间感知模型 LingBot-Depth配合,LingBot-VLA 能获得更高质量的深度信息表征,通过“视力”的升级,真正做到“看得更清楚、做的更明白”。

LingBot-VLA 凭借扎实的基座能力,大幅降低了下游任务的适配门槛,仅需 80 条演示数据即可实现高质量的任务迁移。此外,配合底层代码库的深度优化,其训练效率达到 StarVLA、OpenPI 等主流框架的 1.5~2.8 倍,实现了数据与算力成本的双重降低。

此次开源不仅提供了模型权重,还同步开放了包含数据处理、高效微调及自动化评估在内的全套代码库。这一举措大幅压缩了模型训练周期,降低了商业化落地的算力与时间门槛,助力开发者以更低成本快速适配自有场景,模型实用性大幅提升。

蚂蚁灵波科技CEO朱兴表示,“具身智能要想大规模应用,依赖高效的具身基座模型,这直接决定了是否可用以及能否用得起。我们希望通过LingBot-VLA的开源,积极探索具身智能上限,推进具身智能研发早日进入可复用、可验证、可规模化落地的新阶段,让AI加速在物理世界渗透普及,更早的服务每一个人。”

LingBot-VLA是蚂蚁开源的第一款具身智能基座模型,也是蚂蚁在AGI研发上又一探索性成果。朱兴介绍,蚂蚁集团坚定以开源开放模式探索 AGI,为此打造 InclusionAI,构建了涵盖基础模型、多模态、推理、新型架构及具身智能的完整技术体系与开源生态。LingBot-VLA的开源,正是InclusionAI的关键实践。“期待携手全球开发者,加速具身智能技术的迭代与规模化应用,助力 AGI 更快到来。”

据悉,在数据采集阶段,LingBot-VLA 使用了星海图、松灵的硬件平台,乐聚、库帕思、国家地方共建人形机器人创新中心、北京人形机器人创新中心有限公司、博登智能、睿尔曼也在模型预训练阶段提供了高质量数据支持。目前,LingBot-VLA 已与星海图、松灵、乐聚等厂商完成适配,验证了模型在不同构型机器人上的跨本体迁移能力。